L’effet néfaste d’un produit dangereux en milieu de travail peut se faire ressentir immédiatement ou très peu de temps après l’exposition de l’opérateur à ce produit.Il peut aussi se faire ressentir longtemps après une exposition plus ou moins prolongée, parfois jusqu’à plusieurs dizaines d’années après la fin de l’exposition .

L’effet néfaste d’un produit dangereux en milieu de travail peut se faire ressentir immédiatement ou très peu de temps après l’exposition de l’opérateur à ce produit.Il peut aussi se faire ressentir longtemps après une exposition plus ou moins prolongée, parfois jusqu’à plusieurs dizaines d’années après la fin de l’exposition .

Par ailleurs, un même produit peut avoir, et des effets immédiats, et des effets différés, mais de nature différente, sans qu’il soit possible d’extrapoler sa toxicité prolongée à partir de sa toxicité immédiate.

Autrement dit, la toxicité immédiate d’un produit ne dit rien de sa toxicité à long terme, cette dernière mettant en jeu des mécanismes de nature différente de la première.

On opère donc une distinction entre toxicité aiguë (ou toxicité à court terme) et toxicité chronique (toxicité à long terme). On parle également de toxicité subaiguë.

Toxicité aigue

La toxicité aiguë est définie comme celle qui résulte de l’exposition unique et massive (ou de doses ramassées dans le temps) à un produit chimique entraînant des dommages corporels pouvant conduire à la mort.

Elle introduit la notion de dose « absorbée » ( par ingestion, inhalation ou contact cutané) et se mesure par la DL 50 (dose létale, ou dose provoquant la mort de 50% des animaux exposés à une dose unique du produit incriminé), exprimée en mg/kg de l’animal d’expérience retenu, par exemple le rat mâle par voie orale (per os) .

C’est ce critère de DL50 qui permet aujourd’hui de procéder au classement des substances chimiques en vue de leur étiquetage réglementaire toxique, corrosif, nocif ou irritant.

La notion de DL 50 est remplacée par celle de CL 50 ( concentration létale) lorsque la toxicité étudiée est celle qui est liée non pas à l’ingestion du produit mais à son inhalation.

Pus la DL50 (ou la CL 50) est basse, autrement dit plus le produit testé produit des effets néfastes à faible dose, plus sa toxicité est grande.

La toxicité aiguë, extrêmement variable d’un produit à l’autre, peut se manifester par :

- une dépression du système nerveux central (perte de connaisance, coma…, arrêt cardiaque),

- des effets cutanés (dermite, allergie, brûlure…)

- un accident pulmonaire (oedème aigu du poumon)

- des atteintes oculaires (irritation, lésion de la cornée, cécité,

- etc…

Exemples de toxicité aiguë exprimée en mg/kg chez le rat mâle par voie orale :

Produit chimique DL 50

Ethanol : 7060

Chlorure de sodium : 3000

Cyanure de potassium : 50

Anhydride arsenieux : 1,5

Dioxine (TCDD) 0,02

Toxicité chronique

La toxicité chronique est le résultat de l’exposition prolongée à plus ou moins faible dose à un xénobiotique toxique dont les effets néfastes ne se feront sentir que quelques mois à quelques années voire dizaines d’années plus tard.

Les pathologies peuvent apparaître durant l’exposition ou bien après la cessation de celle-ci. Elles peuvent être le résultat d’une exposition conjuguée à plusieurs toxiques, parfois difficile à déceler. Le mécanisme d’action du toxique lui même peut être complexe et indirect. Il peut se traduire par l’apparition d ‘asthmes, de pneumoconioses, d’encéphalopathies, de paralysies, de cancers…

On peut citer comme exemples d’agents connus pour leur toxicité chronique l’amiante, le plomb, le benzène, la silice, le mercure, les solvants chlorés, certains éthers de glycol…Mais il en existe de très nombreux autres.

A la différence de la toxicité aiguë, la toxicité chronique ne se propose pas de déterminer un seuil de mortalité mais plutôt la dose quotidienne administrée en dessous de laquelle n’apparaissent pas d’effets sur la santé.

Cette notion de seuil doit permettre d’élaborer des valeurs limites d’exposition des opérateurs, leur garantissant l’absence de risque lorsque leur travail s’effectue largement en dessous des limites fixées (cf. fiche N°49 ).

Cependant, la toxicité chronique fait entrer en jeu de nombreux facteurs susceptibles de faire varier la réponse de l’organisme en fonction des individus. On parle de susceptibilité individuelle : l’âge, le sexe, les habitudes alimentaires, le tabagisme, l’alcool, les facteurs génétiques…Ces éléments rendent difficiles la détermination de seuils d’innocuité.

Par ailleurs, la notion de seuil d’exposition apparaît inadaptée en matière de cancers car, même s’il est admis que dans la pratique une certaine quantité de produit est nécessaire pour initier un cancer, il est en théorie possible que la mutation d’une seule cellule normale par une molécule cancérogène entraine la transformation de cette cellule en cellule maligne.

Toxicité subaiguë

La toxicité subaiguë enfin, correspond à un stade d’exposition intermédiaire de l’ordre de trois mois. A la différence de la toxicité aiguë elle permet d’identifier et donc de prévoir les organes cibles sur lesquels un produit exercera également une action en cas d’intoxication chronique.

Ainsi par exemple, un produit exerçant une toxicité sur le foie après trois mois d’exposition (hépatite…), sera probablement également responsable de pathologies sur ce même organe en cas d’exposition à long terme (cirrhose ou autre pathologie hépatique…)

En résumé, l’action des toxiques peut se manifester à court, moyen ou long terme mais cette action varie notamment en fonction de la dose à laquelle la personne est exposée.

Le droit de retrait permet au salarié de cesser son travail en présence d'un danger grave et imminent pour sa vie ou sa santé (art. L. 231-8-1 du Code du travail)

Le droit de retrait permet au salarié de cesser son travail en présence d'un danger grave et imminent pour sa vie ou sa santé (art. L. 231-8-1 du Code du travail)

Jusqu'à présent il a été question de maintenance sans en aborder l'aspect pratique.

Jusqu'à présent il a été question de maintenance sans en aborder l'aspect pratique.

Technique spécifique de la sûreté de fonctionnement, l'Analyse des Modes de Défaillance, de leurs Effets et de leur Criticité (AMDEC) est avant tout une méthode d'analyse de systèmes (systèmes au sens large composé d'éléments fonctionnels ou physiques, matériels, logiciels, humains ...), statique, s'appuyant sur un raisonnement inductif (causes conséquences), pour l'étude organisée des causes, des effets des défaillances et de leur criticité.

Technique spécifique de la sûreté de fonctionnement, l'Analyse des Modes de Défaillance, de leurs Effets et de leur Criticité (AMDEC) est avant tout une méthode d'analyse de systèmes (systèmes au sens large composé d'éléments fonctionnels ou physiques, matériels, logiciels, humains ...), statique, s'appuyant sur un raisonnement inductif (causes conséquences), pour l'étude organisée des causes, des effets des défaillances et de leur criticité.

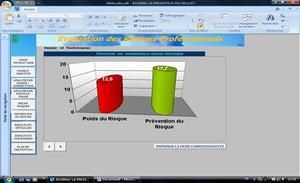

L’évaluation des risques professionnels est obligatoire depuis le 31 décembre 1992, date de l’entrée en vigueur de la loi de 1991 (L. n°91-1414, 31déc. 1991) transposant la Directive-cadre du Conseil du 12 juin 1989 (Dir. 89/391/CEE du Conseil, 12 juin 1989), qui constitue le socle de la politique sociale de l’Union européenne en matière de conditions de travail.

L’évaluation des risques professionnels est obligatoire depuis le 31 décembre 1992, date de l’entrée en vigueur de la loi de 1991 (L. n°91-1414, 31déc. 1991) transposant la Directive-cadre du Conseil du 12 juin 1989 (Dir. 89/391/CEE du Conseil, 12 juin 1989), qui constitue le socle de la politique sociale de l’Union européenne en matière de conditions de travail.  L’effet néfaste d’un produit dangereux en milieu de travail peut se faire ressentir immédiatement ou très peu de temps après l’exposition de l’opérateur à ce produit.Il peut aussi se faire ressentir longtemps après une exposition plus ou moins prolongée, parfois jusqu’à plusieurs dizaines d’années après la fin de l’exposition .

L’effet néfaste d’un produit dangereux en milieu de travail peut se faire ressentir immédiatement ou très peu de temps après l’exposition de l’opérateur à ce produit.Il peut aussi se faire ressentir longtemps après une exposition plus ou moins prolongée, parfois jusqu’à plusieurs dizaines d’années après la fin de l’exposition .  « OHSAS Health and Safety Assessment Series » est l’abréviation anglaise de « Sécurité et Santé au travail ou Bien-être au travail ».

« OHSAS Health and Safety Assessment Series » est l’abréviation anglaise de « Sécurité et Santé au travail ou Bien-être au travail ».